IOSG Ventures:同質化AI基礎設施的出路在哪兒?

感謝來自 Zhenyang@Upshot, Fran@Giza, Ashely@Neuronets, Matt@Valence, Dylan@Pond 的反饋。

本研究旨在探討對开發者而言哪些人工智能領域最為重要,以及在 Web3 和人工智能領域哪些可能是爆發的下一個機遇。

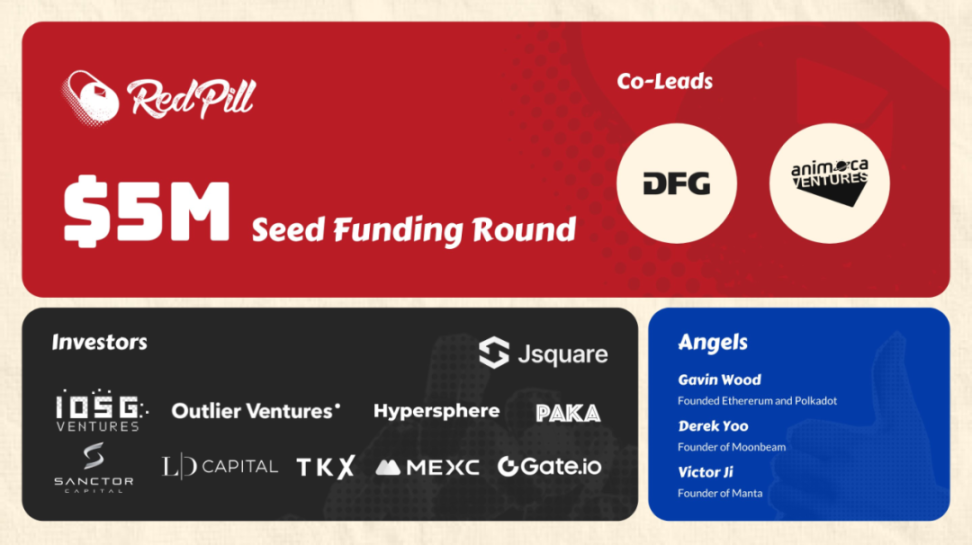

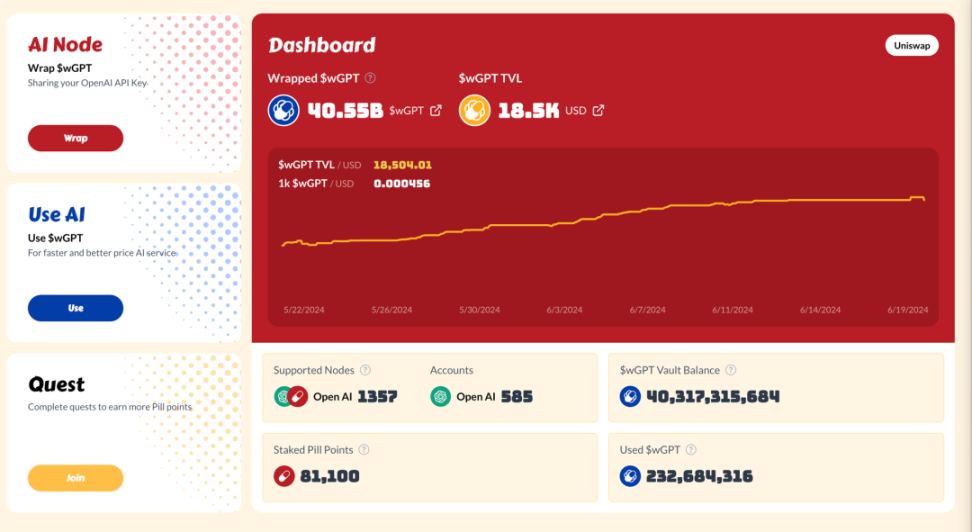

在分享新的研究觀點之前,首先很高興我們參與了 RedPill 總計 500 萬美元的第一輪融資,也非常激動,期待接下來能夠和 RedPill 共同成長!

TL;DR

隨着 Web3 與 AI 的結合成為加密貨幣界的矚目話題,加密世界的 AI 基礎設施構建興旺起來,但實際利用 AI 或為 AI 構建的應用程序並不多,AI 基礎設施的同質化問題逐漸顯現。近期我們參與的 RedPill 的第一輪融資,引發了一些更深入的理解。

-

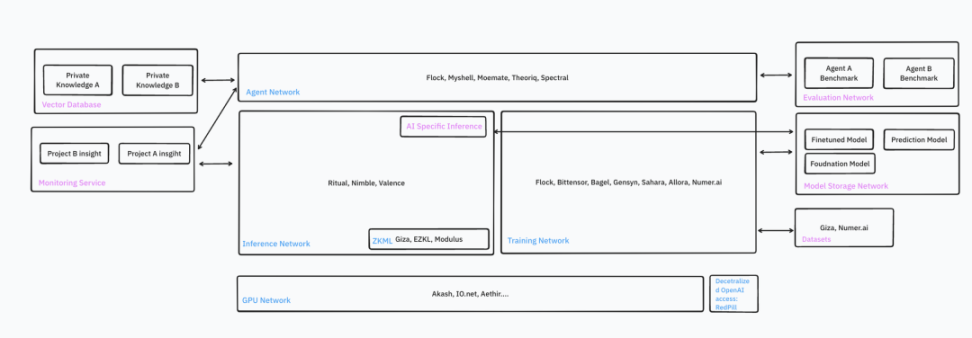

構建 AI Dapp 的主要工具包括去中心化 OpenAI 訪問、GPU 網絡、推理網絡和代理網絡。

-

之所以說 GPU 網絡比「比特幣挖礦時期」還要熱門,是因為:AI 市場更大,並且增長快速且穩定;AI 每天支持數以百萬計的應用程序;AI 需要多樣化的 GPU 型號和服務器位置;技術比過往更成熟;面向的客戶群也更廣。

-

推理網絡和代理網絡有相似的基礎設施,但關注點不同。推理網絡主要供有經驗的开發者部署自己的模型,而運行非 LLM 模型並不一定需要 GPU。代理網絡則更專注於 LLM,开發者無需自帶模型,而是更注重提示工程和如何將不同的代理聯結起來。代理網絡總是需要高性能的 GPU。

-

AI 基礎設施項目承諾巨大,仍在不斷推出新功能。

-

多數原生加密項目仍處於測試網階段,穩定性差,配置復雜,功能受限,還需要時間來證明其安全性和隱私性。

-

假設 AI Dapp 成為大趨勢,還有許多未开發的領域,如監控、與 RAG 相關的基礎設施、Web3 原生模型、內置加密原生 API 和數據的去中心化代理、評估網絡等。

-

垂直整合是一個顯著趨勢。基礎設施項目試圖提供一站式服務,簡化 AI Dapp 开發者的工作。

-

未來將是混合型的。部分推理在前端進行,而部分在鏈上計算,這樣做可以考慮到成本和可驗證性因素。

Source: IOSG

Source: IOSG

引言

-

Web3 與 AI 的結合是當前加密領域中最受矚目的話題之一。才華橫溢的开發者正在為加密世界構建 AI 基礎設施,致力於將智能帶入智能合約。構建 AI dApp 是極其復雜的任務,开發者需要處理的範圍包括數據、模型、計算力、操作、部署和與區塊鏈的整合。針對這些需求,Web3 創始人已經开發出許多初步的解決方案,如 GPU 網絡、社區數據標注、社區訓練的模型、可驗證的 AI 推理與訓練以及代理商店。

-

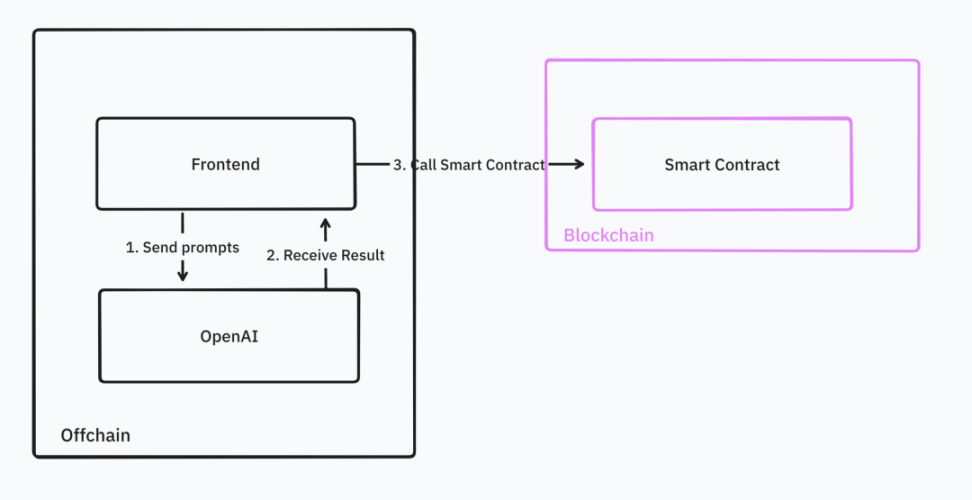

而在這興旺的基礎設施背景下,實際利用 AI 或為 AI 構建的應用程序並不多。开發者在查找 AI dApp 开發教程時,發現這些與原生加密 AI 基礎設施相關的教程並不多,大多數教程僅涉及在前端調用 OpenAI API。

Source: IOSG Ventures

Source: IOSG Ventures

-

當前的應用未能充分發揮區塊鏈的去中心化和可驗證功能,但這種狀況很快將會改變。現在,大多數專注於加密領域的人工智能基礎設施已經啓動了測試網絡,並計劃在未來 6 個月內正式運行。

-

本研究將詳細介紹加密領域人工智能基礎設施中可用的主要工具。讓我們准備迎接加密世界的 GPT-3.5 時刻吧!

1. RedPill:為 OpenAI 提供去中心化授權

前文所提到的我們參投的 RedPill 是一個很好的引入點。

OpenAI 擁有幾種世界級強大的模型,如 GPT-4-vision、GPT-4-turbo 和 GPT-4 o,是構建先進人工智能 Dapp 的優選。

开發者可以通過預言機或前端接口調用 OpenAI API 以將其集成到 dApp 中。

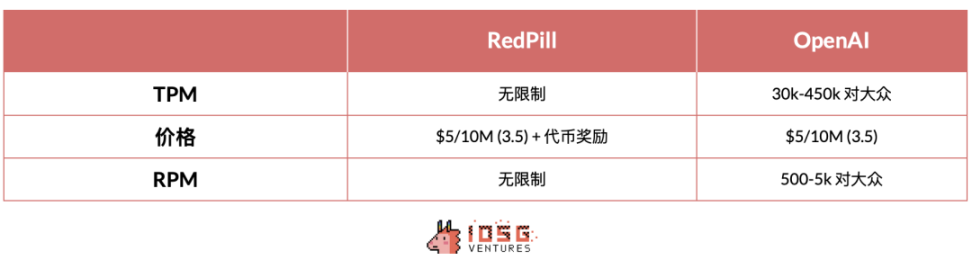

RedPill 將不同开發者的 OpenAI API 整合在一個接口下,為全球用戶提供快速、經濟且可驗證的人工智能服務,從而實現了對頂尖人工智能模型資源的民主化。RedPill 的路由算法會將开發者的請求定向到單一貢獻者處。API 請求將通過其分發網絡執行,從而繞過任何來自 OpenAI 的可能限制,解決了加密开發者面臨的一些常見問題,如:

-

限制 TPM(每分鐘代幣):新账戶對代幣的使用有限,無法滿足熱門且依賴 AI 的 dApp 的需求。

-

訪問限制:一些模型對新账戶或某些國家的訪問設置了限制。

通過使用相同的請求代碼但更換主機名,开發者能以低廉的成本、高擴展性和無限制的方式訪問 OpenAI 模型。

2. GPU 網絡

除了使用 OpenAI 的 API,許多开發人員還會選擇自行在家中托管模型。他們可以依托去中心化 GPU 網絡,如 io.net、Aethir、Akash 等流行的網絡,自行建立 GPU 集群並部署及運行各種強大的內部或开源模型。

這樣的去中心化 GPU 網絡,能夠借助個人或小型數據中心的計算力,提供靈活的配置、更多的服務器位置選擇以及更低的成本,讓开發人員可以在有限的預算內輕松進行 AI 相關的試驗。然而,由於去中心化的性質,此類 GPU 網絡在功能性、可用性和數據隱私方面還存在一定的局限。

過去幾個月,GPU 的需求火爆,超過了之前的比特幣挖礦熱潮。此現象的原因包括:

-

目標客戶增多,GPU 網絡現在服務於 AI 开發者,他們的數量不僅龐大而且更為忠實,不會受到加密貨幣價格波動的影響。

-

相比挖礦專用設備,去中心化 GPU 提供了更多的型號和規格,更能滿趡 iez 要求。尤其是大型模型處理需要更高的 VRAM,而小型任務則有更適合的 GPU 可選。同時,去中心化 GPU 能夠近距離服務終端用戶,降低延遲。

-

技術日趨成熟,GPU 網絡依賴高速區塊鏈如 Solana 結算、Docker 虛擬化技術和 Ray 計算集群等。

-

在投資回報方面,AI 市場正在擴張,新應用和模型的开發機會多,H 100 模型的預期回報率為 60-70% ,而比特幣挖礦則更為復雜,贏家通喫,產量有限。

-

比特幣挖礦企業如 Iris Energy、Core Scientific 和 Bitdeer 也开始支持 GPU 網絡,提供 AI 服務,並積極購买專為 AI 設計的 GPU,如 H 100 。

推薦:對於不太重視 SLA 的 Web2 开發者,io.net 提供了簡潔易用的體驗,是個性價比很高的選擇。

3. 推理網絡

這是加密原生 AI 基礎設施的核心。它將在未來支持數十億次 AI 推理操作。許多 AI layer 1 或 layer 2 為开發者提供了在鏈上原生調用 AI 推理的能力。市場領導者包括 Ritual、Valence 和 Fetch.ai。

這些網絡在以下方面存在差異:

-

性能(延遲、計算時間)

-

支持的模型

-

可驗證性

-

價格(鏈上消耗成本、推理成本)

-

开發體驗

3.1 目標

理想的情況是,开發者可以在任何地方,通過任何形式的證明,輕松地訪問自定義的 AI 推理服務,整合過程中幾乎沒有任何阻礙。

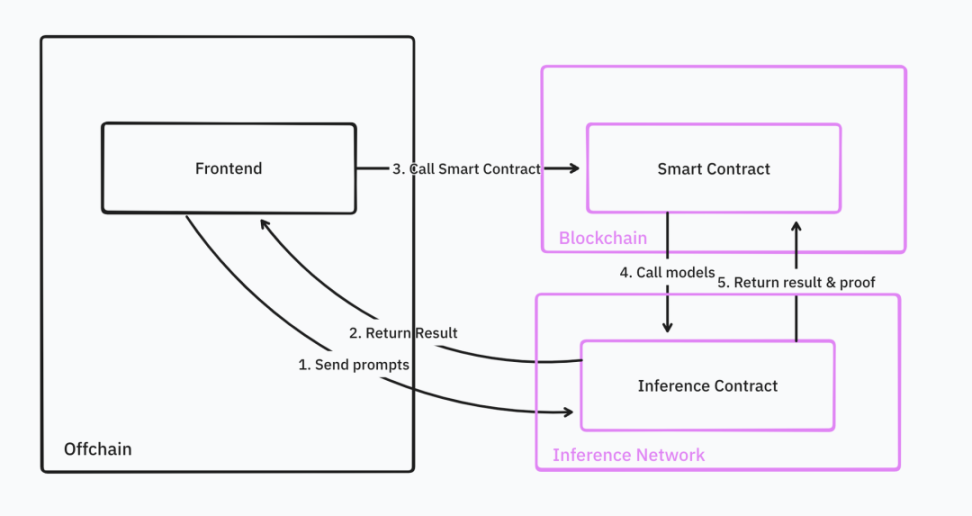

推理網絡提供了开發者所需的全部基礎支持,包括按需生成和驗證證明、進行推理計算、推理數據的中繼和驗證、提供 Web2 和 Web3 的接口、一鍵式模型部署、系統監測、跨鏈操作、同步集成及定時執行等功能。

Source: IOSG Ventures

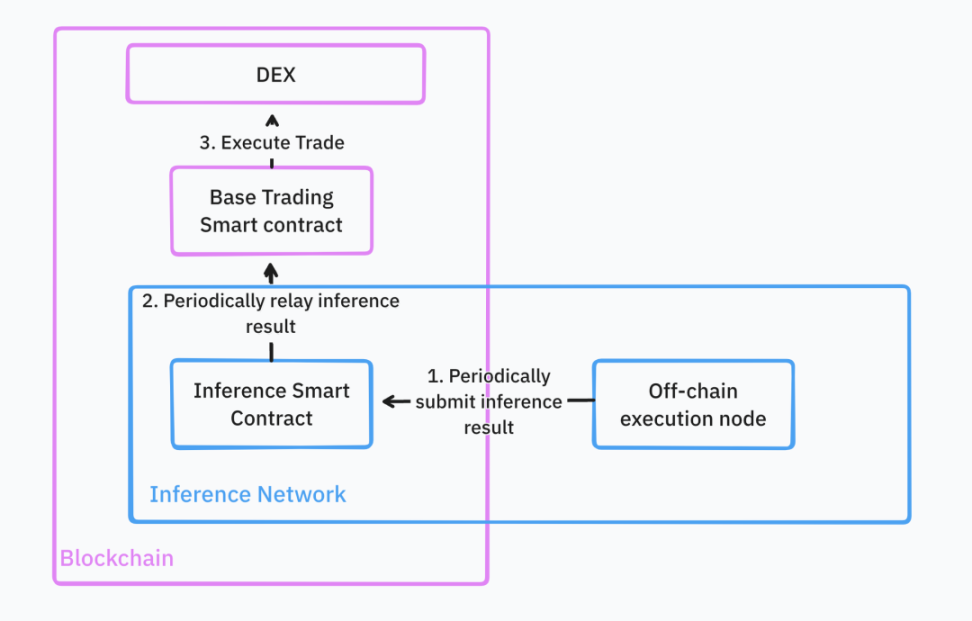

借助這些功能,开發者可以將推理服務無縫集成到他們現有的智能合約中。例如,在構建 DeFi 交易機器人時,這些機器人會利用機器學習模型尋找特定交易對的买賣時機,並在基礎交易平臺上執行相應的交易策略。

在完全理想的狀態下,所有的基礎結構都是雲托管的。开發者只需將他們的交易策略模型以通用格式如 torch 上傳,推理網絡就會存儲並為 Web2 和 Web3 查詢提供模型。

所有模型部署步驟完成後,开發者可以直接通過 Web3 API 或智能合約調用模型推理。推理網絡將持續執行這些交易策略,並將結果反饋給基礎智能合約。如果开發者管理的社區資金量很大,還需要提供推理結果的驗證。一旦收到推理結果,智能合約就會根據這些結果進行交易。

Source: IOSG Ventures

3.1.1 異步與同步

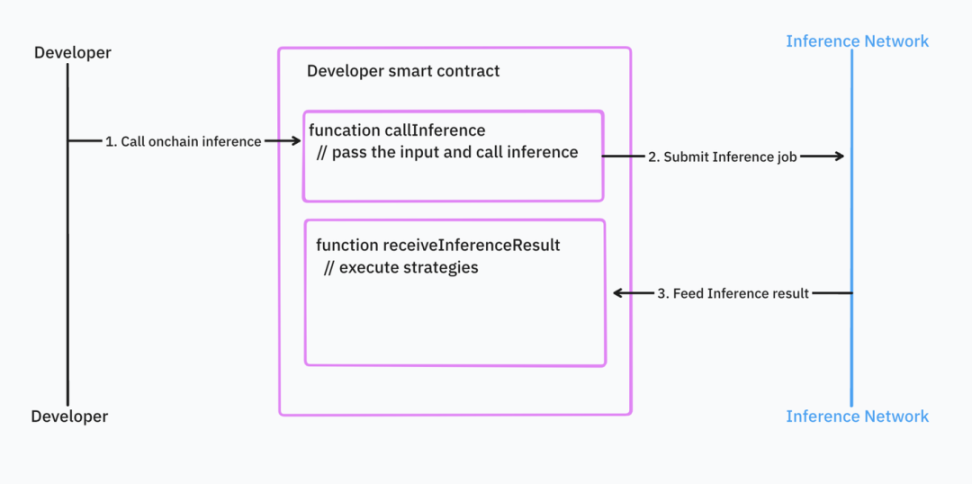

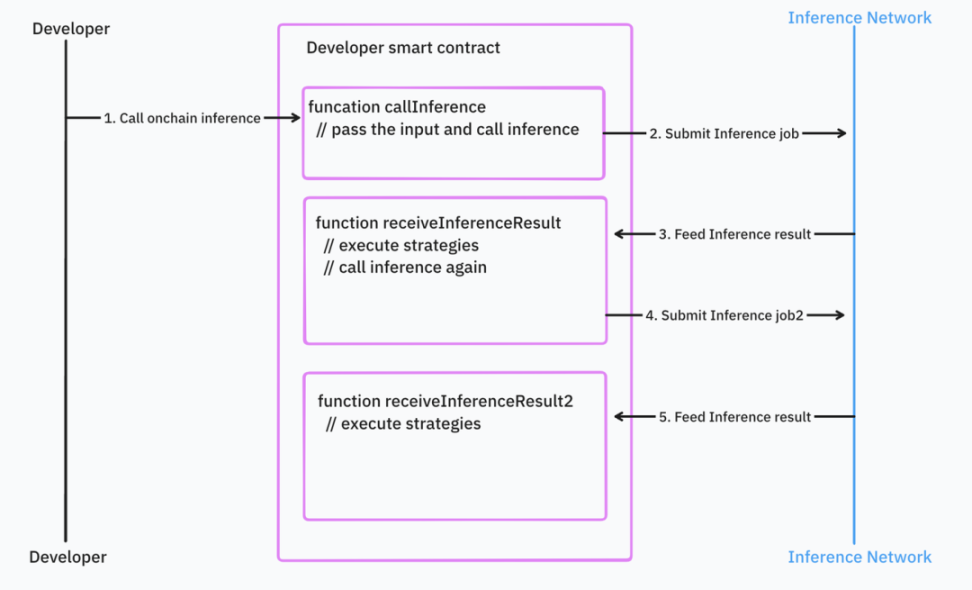

從理論上講,異步執行的推理操作可以帶來更好的性能表現;然而,這種方式在开發體驗上可能讓人感到不便。

在採用異步方式時,开發者需要先將任務提交到推理網絡的智在合約中。當推理任務完成後,推理網絡的智能合約會將結果返回。在這種編程模式下,邏輯被分為推理調用和推理結果處理兩個部分。

Source: IOSG Ventures

如果开發者有嵌套的推理調用和大量的控制邏輯,情況會變得更糟。

Source: IOSG Ventures

異步編程模式使得它難以與現有的智能合約集成。這需要开發者編寫大量額外的代碼,並進行錯誤處理和管理依賴關系。

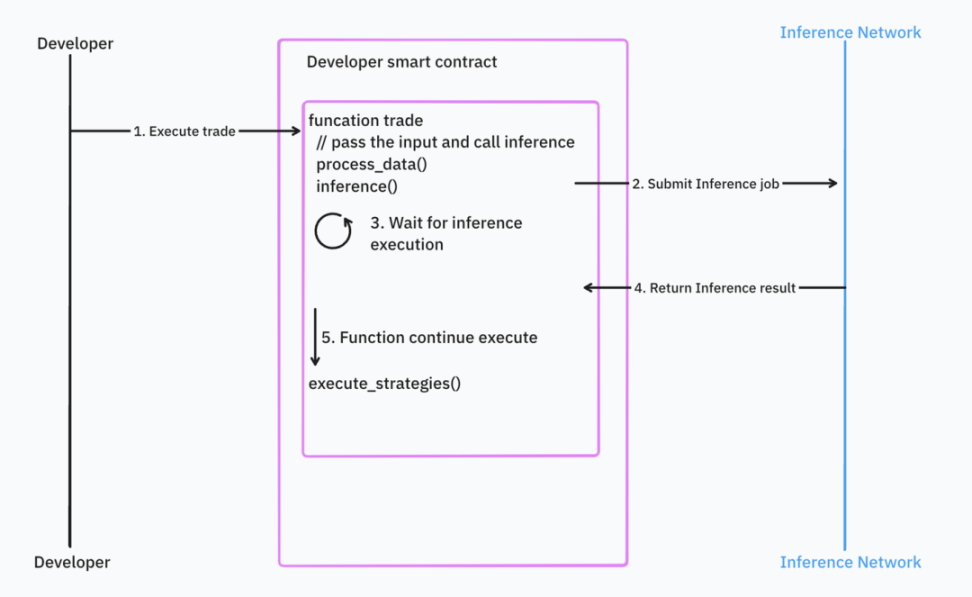

相對地,同步編程對於开發者來說更加直觀,但它在響應時間和區塊鏈設計上引入了問題。例如,如果輸入數據是區塊時間或者價格這種快速變動的數據,那么在推理完成後數據已不再新鮮,這可能會導致在特定情況下智能合約的執行需要回滾。想象一下,你用一個過時的價格來做交易。

Source: IOSG Ventures

大部分 AI 基礎架構採用異步處理,但 Valence 正在嘗試解決這些問題。

3.2 現實情況

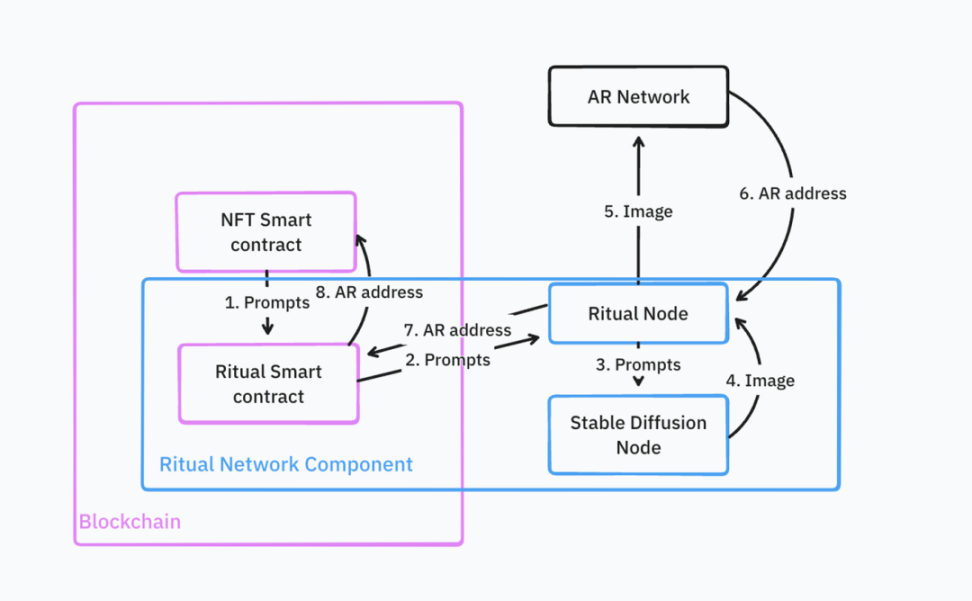

實際上,許多新的推理網絡還在測試階段,如 Ritual 網絡。根據他們的公开文件,這些網絡目前的功能較為有限(諸如驗證、證明等功能還未上线)。他們目前沒有提供一個雲基礎設施以支持鏈上 AI 計算,而是提供了一個框架,用於自我托管 AI 計算並將結果傳遞至鏈上。

這是一個運行 AIGC NFT 的體系結構。擴散模型生成 NFT 並上傳至 Arweave。推理網絡會用這個 Arweave 地址在鏈上鑄造該 NFT。

Source: IOSG Ventures

這個過程非常復雜,开發者需要自己部署和維護大多數基礎設施,如配有定制服務邏輯的 Ritual 節點、Stable Diffusion 節點及 NFT 智能合約。

推薦:目前的推理網絡在整合和部署自定義模型方面相當復雜,且在這一階段大多數網絡還不支持驗證功能。將 AI 技術應用到前端會為开發者提供一個相對簡單的選擇。如果你非常需要驗證功能,ZKML 提供商 Giza 是個不錯的選擇。

4. 代理網絡

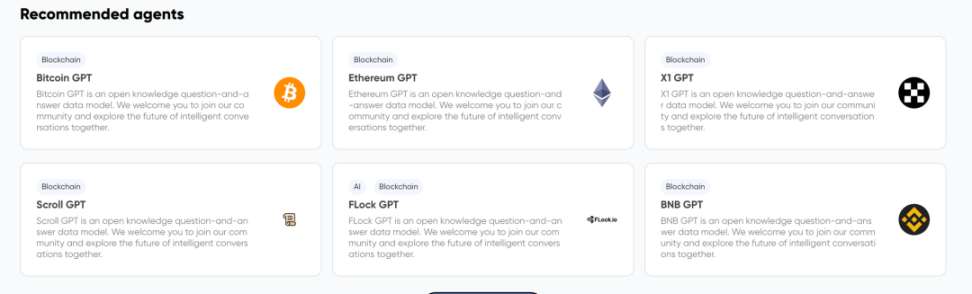

代理網絡讓用戶能輕松自定義代理。這樣的網絡由能自主執行任務、相互交雲以及與區塊鏈網絡交互的實體或智能合約組成,這一切無需人工直接幹預。它主要針對 LLM 技術。例如,它可以提供一個深入了解以太坊的 GPT 聊天機器人。這種聊天機器人目前的工具較為有限,开發者還不能在此基礎上开發復雜的應用。

Source: IOSG Ventures

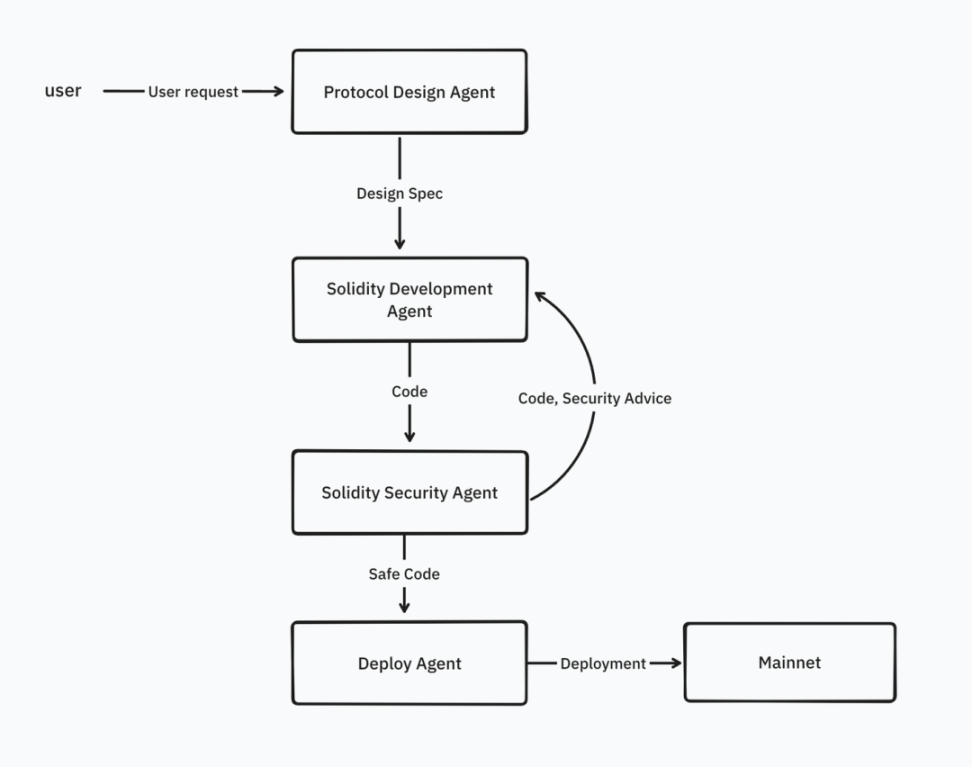

但是將來,代理網絡將提供更多的工具給代理使用,不僅僅是知識,還包括調用外部 API、執行特定任務的能力等。开發者將能夠將多個代理連接起來構建工作流。例如,編寫 Solidity 智能合約會涉及多個專門的代理,包括協議設計代理、Solidity 开發代理、代碼安全審查代理以及 Solidity 部署代理。

Source: IOSG Ventures

我們通過使用提示和場景來協調這些代理的合作。

一些代理網絡的例子包括 Flock.ai、Myshell、Theoriq。

推薦:當今大部分代理的功能都相對有限。對於特定用例,Web2 代理能夠更好的服務,並且擁有成熟的編排工具,例如 Langchain、Llamaindex。

5. 代理網絡與推理網絡的差異

代理網絡更側重於 LLM,提供了如 Langchain 這樣的工具來整合多個代理。通常情況下,开發者無需親自开發機器學習模型,代理網絡已經將模型开發和部署的過程簡化。他們只需要鏈接必要的代理和工具即可。大多數情況下,最終用戶將直接使用這些代理。

推理網絡則是代理網絡的基礎設施支撐。它提供給开發者較低層次的接入權限。正常情況下,終端用戶不直接使用推理網絡。开發者需要部署自己的模型,這不僅限於 LLM,並且他們可以通過鏈下或鏈上接入點使用它們。

代理網絡和推理網絡並非完全獨立的產品。我們已經开始看到一些豎向整合的產品。他們因為這兩種功能依賴相似的基礎設施,所以同時提供代理和推理能力。

6. 新的機會之地

除了模型推理、訓練和代理網絡外,web3 領域還有很多值得探索的新領域:

-

數據集:如何將區塊鏈數據轉變為機器學習可用的數據集?機器學習开發者需要的是更為具體和專題化的數據。例如,Giza 提供了一些高品質的、關於 DeFi 的數據集,專門用於機器學習訓練。理想的數據應不僅僅是簡單的表格數據,還應該包括能夠描述區塊鏈世界交互的圖形數據。目前,我們在這方面還有不足。目前有些項目正通過獎勵個人創建新數據集來解決這一問題,比如 Bagel 和 Sahara,它們承諾保護個人數據的隱私。

-

模型存儲:一些模型體積龐大,如何存儲、分發及版本控制這些模型是關鍵,這關系到鏈上機器學習的性能和成本。在這一領域,Filecoin, AR 和 0 g 等先鋒性項目已經取得了進展。

-

模型訓練:分布式且可驗的模型訓練是個難題。Gensyn, Bittensor, Flock 和 Allora 等已有顯著進展。

-

監控:由於模型推理在鏈上與鏈下都有發生,我們需要新的基礎設施來幫助 web3 开發者追蹤模型的使用狀況,及時發現可能存在的問題和偏差。有了合適的監控工具,web3 的機器學習开發者可以及時調整,不斷優化模型精確度。

-

RAG 基礎設施:分布式 RAG 需要全新的基礎設施環境,對存儲、嵌入計算和向量數據庫有較高的需求,同時要確保數據的隱私安全。這與目前的 Web3 AI 基礎設施大不相同,後者大多依賴第三方來完成 RAG,例如 Firstbatch 和 Bagel。

-

專為 Web3 定制的模型:並不是所有模型都適合 Web3 情景。大多數情況下,需要對模型進行重新訓練,以適應價格預測、推薦等具體應用。隨着 AI 基礎設施的繁榮發展,未來我們期望有更多 web3 本地模型來服務於 AI 應用。比如 Pond 正在开發區塊鏈 GNN,用於價格預測、推薦、欺詐偵測和反洗錢等多種場景。

-

評估網絡:在缺乏人類反饋的情況下評估代理是不容易的。隨着代理創建工具的普及,市場上將會出現無數的代理。這就需要有一個系統來展示這些代理的能力,並幫助用戶判斷在特定情況下哪個代理的表現最佳。例如,Neuronets 是這個領域的一個參與者。

-

共識機制:對於 AI 任務,PoS 不一定是最佳選擇。計算復雜性、驗證的困難和確定性的缺失是 PoS 面臨的主要挑战。Bittensor 創造了一種新的智慧型共識機制,獎勵網絡中為機器學習模型和輸出做出貢獻的節點。

7. 未來展望

我們目前觀察到了垂直整合的發展趨勢。通過構建一個基礎的計算層,網絡能夠為多種機器學習任務提供支持,包括訓練、推理及代理網絡服務。這種模式意在為 Web3 的機器學習开發者們提供全方位的一站式解決方案。

目前,鏈上推理盡管成本高昂且速度較慢,但它提供了出色的可驗證性及與後端系統(例如智能合約)的無縫集成。我認為未來將走向混合應用的道路。一部分推理處理將在前端或鏈下進行,而那些關鍵的、決策性的推理則會在鏈上完成。這種模式已經在移動設備上得到了應用。通過利用移動設備的本質特點,它能夠在本地快速運行小型模型,並將更復雜的任務遷移到雲端,利用較大的 LLM 處理。

鄭重聲明:本文版權歸原作者所有,轉載文章僅為傳播信息之目的,不構成任何投資建議,如有侵權行為,請第一時間聯絡我們修改或刪除,多謝。

星球日報

文章數量

7691粉絲數

0