IOSG Ventures:GPU供應危機,初創AI企業破局之路

原文作者:Mohit Pandit, IOSG Ventures

摘要

-

GPU 短缺是現實,供需緊張,但未充分利用的 GPU 數量可以滿足當今供應緊缺的需求。

-

需要一個激勵層來促進雲計算的參與,然後最終協調用於推理或訓練的計算任務。DePIN 模型正好適合這一用途。

-

因為供應方的激勵,因為計算成本較低,需求方發現這很吸引人。

-

並非一切都是美好的,選擇Web3雲時必須做出某些權衡:比如‘延遲’。相對於傳統的 GPU 雲,面臨的權衡還包括保險、服務水平協議 (Service Level Agreements) 等。

-

DePIN 模型有潛力解決 GPU 可用性問題,但碎片化模型不會使情況變得更好。對於需求呈指數級增長的情況,碎片化供應和沒有供應一樣。

-

考慮到新市場參與者的數量,市場聚合是不可避免的。

引言

我們正處於機器學習和人工智能的新時代邊緣。雖然 AI 已經以各種形式存在一段時間(AI 是被告知執行人類可以做的事情的計算機設備,如洗衣機),但我們現在見證了復雜認知模型的出現,這些模型能夠執行需要智能人類行為的任務。顯著的例子包括 OpenAI 的 GPT-4 和 DALL-E 2 ,以及谷歌的 Gemini。

在迅速增長的人工智能(AI)領域,我們必須認識到發展的雙重方面:模型訓練和推理。推理包括 AI 模型的功能和輸出,而訓練包括構建智能模型所需的復雜過程(包括機器學習算法、數據集和計算能力)。

以 GPT-4 為例,最終用戶關心的只是推理:基於文本輸入從模型獲取輸出。然而,這種推理的質量取決於模型訓練。為了訓練有效的 AI 模型,开發者需要獲得全面的基礎數據集和巨大的計算能力。這些資源主要集中在包括 OpenAI、谷歌、微軟和 AWS 在內的行業巨頭手中。

公式很簡單:更好的模型訓練 >> 導致 AI 模型的推理能力增強 >> 從而吸引更多用戶 >> 帶來更多收入,用於進一步訓練的資源也隨之增加。

這些主要玩家能夠訪問大型基礎數據集,更關鍵的是控制着大量計算能力,為新興开發者創造了進入壁壘。因此,新進入者經常難以以經濟可行的規模和成本獲得足夠的數據或利用必要的計算能力。考慮到這種情況,我們看到網絡在民主化資源獲取方面具有很大價值,主要是與大規模獲取計算資源以及降低成本有關。

GPU 供應問題

NVIDIA 的 CEO Jensen Huang 在 2019 年 CES 上說“摩爾定律已經結束”。今天的 GPU 極度未充分利用。即使在深度學習/訓練周期中,GPU 也沒有被充分利用。

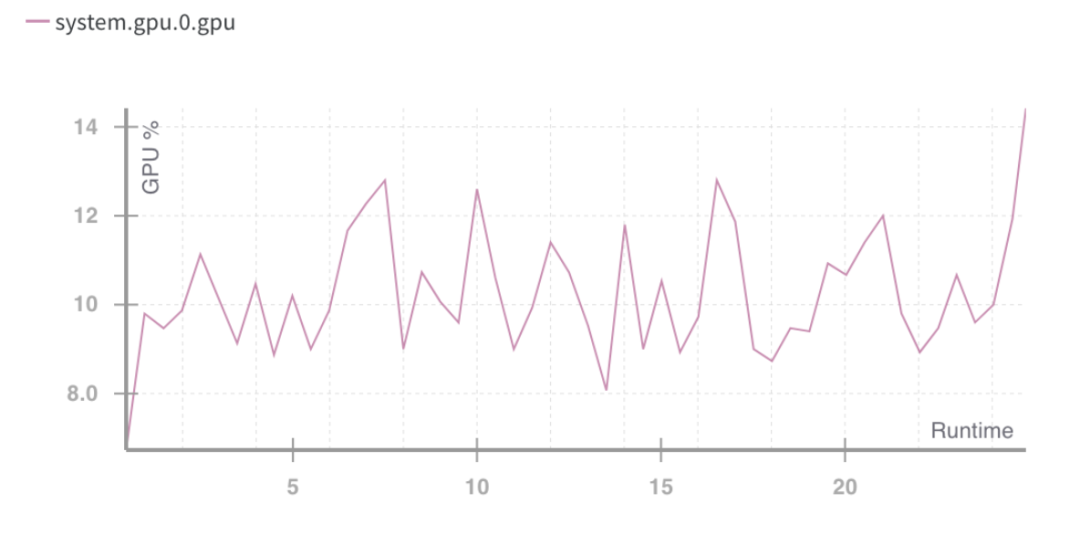

以下是不同工作負載的典型 GPU 利用率數字:

-

空闲(剛剛啓動進入 Windows 操作系統): 0-2%

-

一般生產任務(寫作、簡單瀏覽): 0-15%

-

視頻播放: 15 - 35%

-

PC 遊戲: 25 - 95%

-

圖形設計/照片編輯主動工作負載(Photoshop、Illustrator): 15 - 55%

-

視頻編輯(主動): 15 - 55%

-

視頻編輯(渲染): 33 - 100%

-

3D渲染(CUDA / OptiX): 33 - 100% (常被 Win 任務管理器錯誤報告 - 使用 GPU-Z)

大多數帶 GPU 的消費設備屬於前三類。

GPU 運行時利用率%。Source: Weights and Biases

上述情況指向一個問題:運算資源利用不良。

需要更好地利用消費者 GPU 的容量,即使在 GPU 利用率出現高峯時,也是次優的。這明確了未來要進行的兩件事情:

-

資源(GPU)聚合

-

訓練任務的並行化

可以使用的硬件類型方面,現在有 4 種類型用於供應:

· 數據中心 GPU(例如,Nvidia A 100 s)

· 消費者 GPU(例如,Nvidia RTX 3060)

· 定制 ASIC(例如,Coreweave IPU)

· 消費者 SoCs(例如,蘋果 M 2)

除了 ASIC(因為它們是為特定目的而構建的),其他硬件可以被匯集以最有效地利用。隨着許多這樣的芯片掌握在消費者和數據中心手中,聚合供應方的 DePIN 模型可能是可行的道路。

GPU 生產是一個體量金字塔;消費級 GPU 產量最高,而像 NVIDIA A 100 s 和 H 100 s 這樣的高級 GPU 產量最低(但性能更高)。生產這些高級芯片的成本是消費者 GPU 的 15 倍,但有時並不提供 15 倍的性能。

整個雲計算市場今天價值約 4830 億美元,預計未來幾年將以約 27% 的復合年增長率增長。到 2023 年,將有大約 130 億小時的 ML 計算需求,按照當前標准費率,這相當於 2023 年 ML 計算的約 560 億美元支出。這整個市場也在迅速增長,每 3 個月增長 2 倍。

GPU 需求

計算需求主要來自 AI 开發者(研究人員和工程師)。他們的主要需求是:價格(低成本計算)、規模(大量 GPU 計算)和用戶體驗(易於訪問和使用)。在過去兩年中,由於對基於 AI 的應用程序的需求增加以及 ML 模型的發展,GPU 需求量巨大。开發和運行 ML 模型需要:

-

大量計算(來自訪問多個 GPU 或數據中心)

-

能夠執行模型訓練、微調 ( fine tuning) 以及推理,每個任務都部署在大量 GPU 上並行執行

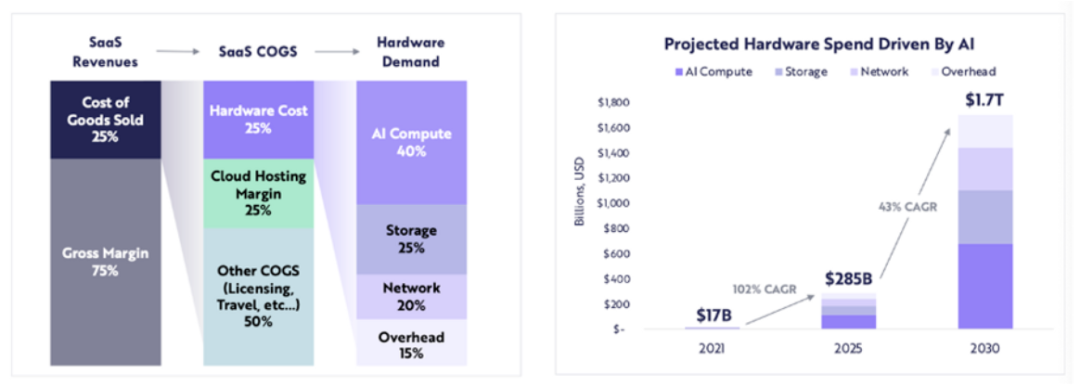

計算相關硬件支出預計將從 2021 年的 170 億美元增長到 2025 年的 2850 億美元(約 102% 的復合年增長率),ARK 預計到 2030 年計算相關硬件支出將達到 1.7 萬億美元(43% 的復合年增長率)。

ARK Research

隨着大量 LLM 處於創新階段,競爭驅動對更多參數的計算需求,以及重新訓練,我們可以預期在未來幾年內對高質量計算的持續需求。

隨着新的 GPU 供應緊縮,區塊鏈在哪裏發揮作用?

當使用資源不足的時候,DePIN 模型就會提供出其幫助:

-

啓動供應方,創建大量供應

-

協調和完成任務

-

確保任務正確完成

-

為完成工作的提供者正確獎勵

聚合任何類型的 GPU(消費者、企業、高性能等)可能會在利用方面出現問題。當計算任務被分割時,A 100 芯片不應該執行簡單的計算。GPU 網絡需要決定他們認為應該包括在網絡中的 GPU 類型,根據他們的市場進入策略。

當計算資源本身分散(有時是全球性的)時,需要由用戶或協議本身做出選擇,決定將使用哪種類型的計算框架。提供者像 io.net 允許用戶從 3 種計算框架中選擇:Ray、Mega-Ray 或部署 Kubernetes 集群在容器中執行計算任務。還有更多分布式計算框架,如 Apache Spark,但 Ray 是最常用的。一旦所選 GPU 完成了計算任務,將重構輸出以給出訓練有素的模型。

一個設計良好的代幣模型將為 GPU 提供者補貼計算成本,許多开發者(需求方)會發現這樣的方案更有吸引力。分布式計算系統本質上具有延遲。存在計算分解和輸出重構。所以开發者需要在訓練模型的成本效益和所需時間之間做出權衡。

分布式計算系統需要有自己的鏈嗎?

網絡有兩種運作方式:

-

按任務(或計算周期)收費或按時間收費

-

按時間單位收費

第一種方法,可以構建一個類似於 Gensyn 所嘗試的工作證明鏈,其中不同 GPU 分擔“工作”並因此獲得獎勵。為了更無信任的模型,他們有驗證者和告密者的概念,他們因保持系統的完整性而獲得獎勵,這是基於解算者生成的證明。

另一個工作證明系統是 Exabits,它不是任務分割,而是將其整個 GPU 網絡視為單個超級計算機。這種模型似乎更適合大型 LLM。

Akash Network 增加了 GPU 支持,並开始聚合 GPU 進入這一領域。他們有一個底層L1來就狀態(顯示 GPU 提供者完成的工作)達成共識,一個市場層,以及容器編排系統,如 Kubernetes 或 Docker Swarm 來管理用戶應用程序的部署和擴展。

一個系統如果要是無信任,工作證明鏈模型將最有效。這確保了協議的協調和完整性。

另一方面,像 io.net 這樣的系統並沒有將自己構建為一個鏈。他們選擇解決 GPU 可用性的核心問題,並按時間單位(每小時)向客戶收費。他們不需要可驗證性層,因為他們本質上是“租用”GPU,在特定租賃期內隨意使用。協議本身沒有任務分割,而是由开發者使用像 Ray、Mega-Ray 或 Kubernetes 這樣的开源框架完成。

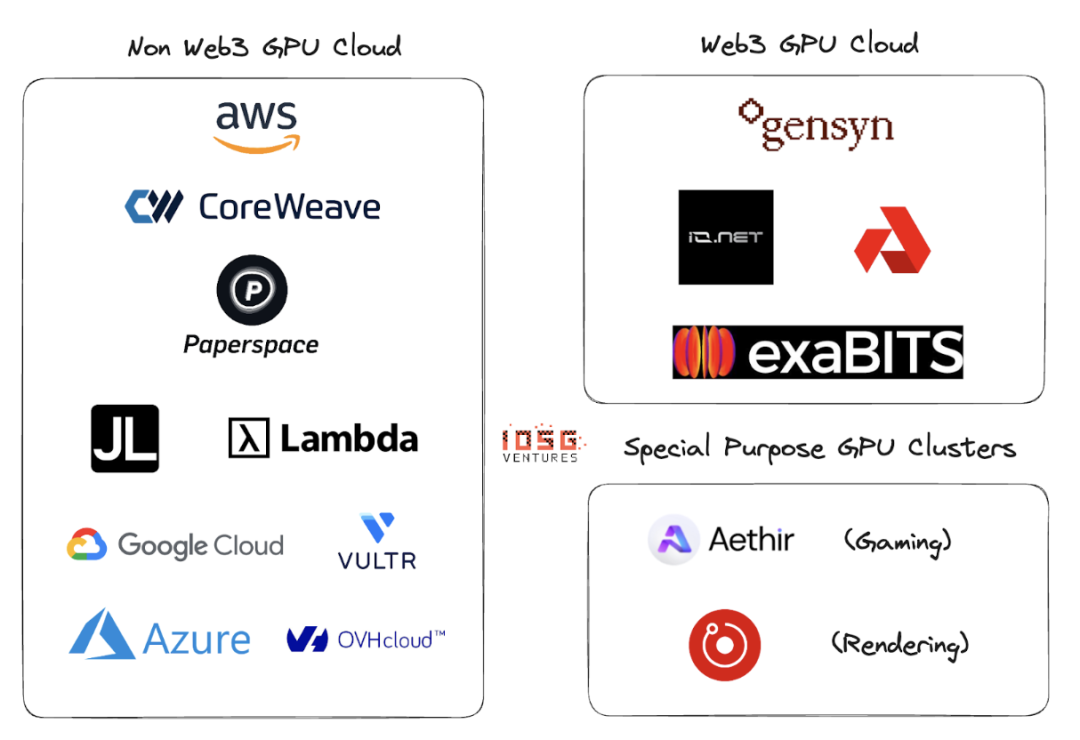

Web2與Web3 GPU 雲

Web2在 GPU 雲或 GPU 即服務領域有很多參與者。這一領域的主要玩家包括 AWS、CoreWeave、PaperSpace、Jarvis Labs、Lambda Labs、谷歌雲、微軟 Azure 和 OVH 雲。

這是一個傳統的雲業務模型,客戶需要計算時可以按時間單位(通常是一小時)租用 GPU(或多個 GPU)。有許多不同的解決方案適用於不同的用例。

Web2和Web3 GPU 雲之間的主要區別在於以下幾個參數:

1. 雲設置成本

由於代幣激勵,建立 GPU 雲的成本顯著降低。OpenAI 正在籌集 1 萬億美元用於計算芯片的生產。看來在沒有代幣激勵的情況下,打敗市場領導者需要至少 1 萬億美元。

2. 計算時間

非Web3 GPU 雲將會更快,因為已租用的 GPU 集群位於地理區域內,而Web3模型可能有一個更廣泛分布的系統,延遲可能來自於低效的問題分割、負載平衡,最重要的是帶寬。

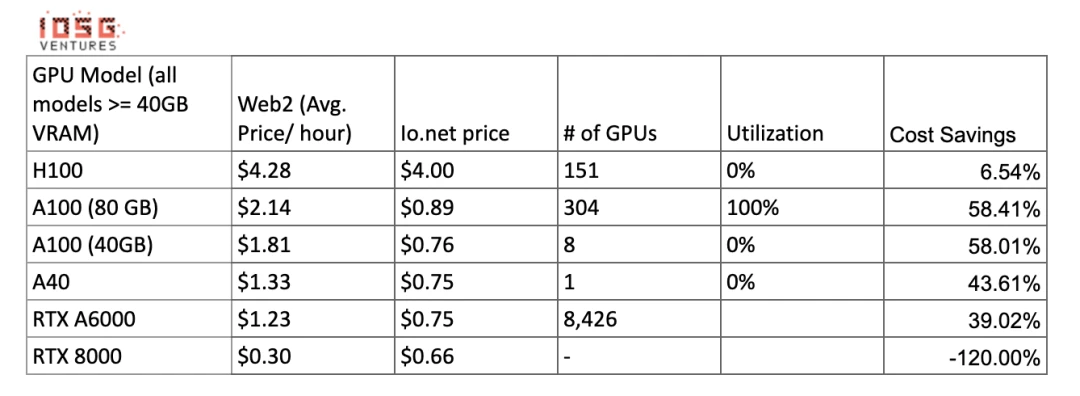

3. 計算成本

由於代幣激勵,Web3計算的成本將顯著低於現有的Web2模型。

計算成本對比:

當有更多供應和利用集群提供這些 GPU 時,這些數字可能會發生變化。Gensyn 聲稱以低至每小時 0.55 美元的價格提供 A 100 s(及其等價物),Exabits 承諾類似的成本節省結構。

4. 合規性

在無許可系統中,合規性並不容易。然而,像 io.net、Gensyn 等Web3系統並不將自己定位為無許可系統。在 GPU 上线、數據加載、數據共享和結果共享階段處理了 GDPR 和 HIPAA 等合規性問題。

生態系統

Gensyn、io.net、Exabits、Akash

風險

1. 需求風險

我認為頂級 LLM 玩家要么會繼續積累 GPU,要么會使用像 NVIDIA 的 Selene 超級計算機這樣的 GPU 集群,後者的峯值性能為 2.8 exaFLOP/s。他們不會依賴消費者或長尾雲提供商匯集 GPU。當前,頂級 AI 組織在質量上的競爭大於成本。

對於非重型 ML 模型,他們將尋求更便宜的計算資源,像基於區塊鏈的代幣激勵 GPU 集群可以在優化現有 GPU 的同時提供服務(以上是假設:那些組織更喜歡訓練自己的模型,而不是使用 LLM)

2. 供應風險

隨着大量資本投入 ASIC 研究,以及像張量處理單元(TPU)這樣的發明,這個 GPU 供應問題可能會自行消失。如果這些 ASIC 可以提供良好的性能:成本權衡,那么大型 AI 組織囤積的現有 GPU 可能會重新回歸市場。

基於區塊鏈的 GPU 集群是否解決了一個長期問題?雖然區塊鏈可以支持除 GPU 之外的任何芯片,但需求方的所作所為將完全決定這一領域內項目的發展方向。

結論

擁有小型 GPU 集群的碎片化網絡不會解決問題。沒有“長尾”GPU 集群的位置。GPU 提供商(零售或較小的雲玩家)將傾向於更大的網絡,因為網絡的激勵更好。會是良好代幣模型的功能,也是供應方支持多種計算類型的能力。

GPU 集群可能會像 CDN 一樣看到類似的聚合命運。如果大型玩家要與 AWS 等現有領導者競爭,他們可能會开始共享資源,以減少網絡延遲和節點的地理接近性。

如果需求方增長得更大(需要訓練的模型更多,需要訓練的參數數量也更多),Web3玩家必須在供應方業務發展方面非常積極。如果有太多的集群從相同的客戶群中競爭,將會出現碎片化的供應(這使整個概念無效),而需求(以 TFLOPs 計)呈指數級增長。

Io.net 已經從衆多競爭者中脫穎而出,以聚合器模型起步。他們已經聚合了 Render Network 和 Filecoin 礦工的 GPU,提供容量,同時也在自己的平臺上引導供應。這可能是 DePIN GPU 集群的贏家方向。

鄭重聲明:本文版權歸原作者所有,轉載文章僅為傳播信息之目的,不構成任何投資建議,如有侵權行為,請第一時間聯絡我們修改或刪除,多謝。

比特幣、以太坊 OTC 市場交易量飆升!機構投資熱潮湧入

近 期加密貨幣場外交易(OTC)市場的交易量激增,美國加密貨幣交易所 Kraken 的機構業務主管...

麻吉大哥轉移總量12%的Cream至幣安,Hyperliquid加持下埋伏暴漲?

2 020 年由麻吉大哥黃立成創辦的借貸平臺 Cream Finance,其平臺幣 $CREAM...

24H熱門幣種與要聞 | 俄羅斯正在對外貿易中使用比特幣;韓國加密投資者數量突破1500萬,交易量比肩股市(12.26)

24 H 熱門幣種 1、CEX 熱門幣種 CEX 成交額 Top 10 及 24 小時漲跌幅: B...

加密時代的職務犯罪:北京億元涉幣職務侵佔案,追贓 8900 萬

撰文:肖颯法律團隊 所謂「職務犯罪」在我國刑法體系中,並非一個單一的罪名,而是指國家機關、國有公司...

星球日報

文章數量

7735粉絲數

0